Índice

- O que é estelionato por meio eletrônico

- Como IAs são usadas em golpes

- Como identificar padrões do uso de IAs em golpes

- Dicas para se proteger

- Na dúvida, fale pessoalmente

- Confira o número de telefone

- Desligue e ligue você para a pessoa, se houver suspeita

- Faça a confirmação com uma videochamada e faça perguntas que só a pessoa real saberia responder

- Não empreste dinheiro sem verificar a identidade alheia

- Observe trejeitos, compare e procure por erros de imagem

O Brasil tem enfrentado um aumento significativo nos casos de estelionato por meio eletrônico, em parte devido ao uso de Inteligência Artificial (IA) por golpistas; é o que apontam os dados do Anuário Brasileiro de Segurança Pública 2023. Com o avanço tecnológico, tornou-se mais fácil para criminosos se passarem por outras pessoas, utilizando IAs para criar perfis falsos e enganar vítimas desavisadas. Essa prática tem intensificado como criminosos clonam pessoas, levando a um aumento nos casos de fraudes online, como golpes financeiros, clonagem de cartões e phishing, prática na qual informações pessoais são obtidas de forma fraudulenta.

O uso de IA nesse contexto tem tornado os golpes mais sofisticados e difíceis de detectar, pois as tecnologias de geração de texto e voz podem criar mensagens e chamadas que se assemelham muito às comunicações reais. Além disso, a capacidade das IAs de analisar grandes quantidades de dados facilita a personalização dos golpes, tornando-os mais convincentes e aumentando a probabilidade de sucesso para os golpistas.

O que é estelionato por meio eletrônico

O estelionato por meio eletrônico é uma forma de crime que envolve o uso de meios eletrônicos, como a internet e dispositivos digitais, para enganar e fraudar pessoas. Esse tipo de golpe abrange uma variedade de práticas fraudulentas, como phishing, clonagem de cartões, falsas promoções, entre outros, que têm o objetivo de obter informações pessoais ou financeiras das vítimas.

É importante ressaltar que o estelionato por meio eletrônico pode ocorrer de diversas formas, desde a criação de páginas falsas para capturar informações pessoais até a simulação de identidades para aplicar golpes financeiros.

De acordo com as estatísticas do Anuário Brasileiro de Segurança Pública de 2023, o número de casos de estelionato por meio eletrônico atingiu 200.322 registros no ano passado. Esse valor representa um aumento significativo de 65% em relação a 2021, quando foram contabilizados 120.470 casos. Os Estados mais afetados por esse tipo de golpe foram:

- Santa Catarina, com 64.230 casos;

- Minas Gerais, com 35.749 casos;

- Distrito Federal, com 15.580 casos;

- Espírito Santo, com 15.277 casos.

Por outro lado, é preocupante o fato de que alguns Estados, como Bahia, Ceará, Rio de Janeiro, Rio Grande do Norte, Rio Grande do Sul e São Paulo não forneceram dados sobre esse tipo de crime até o encerramento da pesquisa, sugerindo uma possível subnotificação ou falta de dados precisos sobre a extensão do problema nessas regiões.

Como IAs são usadas em golpes

As Inteligências Artificiais (IAs) são utilizadas de diversas formas para que golpistas se passem por outras pessoas, aumentando a sofisticação e eficácia dos golpes. Uma das técnicas comuns é a criação de perfis falsos em redes sociais e plataformas de mensagens, onde a IA é usada para gerar informações e fotos que se assemelham a uma pessoa real.

As IAs são capazes de analisar dados disponíveis online, como fotos, postagens, informações pessoais e criar perfis falsos extremamente convincentes. Além disso, as IAs podem imitar a linguagem e o comportamento das pessoas, tornando mais difícil para as vítimas identificar que estão interagindo com uma máquina e não com um ser humano real.

Em geral, as IAs são utilizadas de diversas formas para que golpistas se passem por outras pessoas, tornando mais difícil para as vítimas identificar que estão sendo enganadas. Veja abaixo os golpes mais comuns envolvendo casos de estelionato por meio eletrônico com IAs.

Golpes em ligações de voz

Os golpes em ligações de voz com uso de Inteligência Artificial (IA) têm se tornado mais comuns e sofisticados. Nesse tipo de golpe, os criminosos utilizam programas de IA para simular vozes humanas, imitando pessoas conhecidas das vítimas ou até mesmo autoridades, como representantes de bancos ou empresas. Com isso, os golpistas conseguem enganar as vítimas, solicitando informações pessoais, como senhas bancárias, ou induzindo-as a realizar transferências de dinheiro. Esses golpes são perigosos, pois as vozes falsas podem ser extremamente convincentes, tornando difícil para as vítimas identificarem a fraude.

Uma das primeiras demonstrações públicas de voz sintetizada ocorreu em 1984, quando um computador Apple recitou um texto com uma voz robótica. Desde então, assistimos ao desenvolvimento de assistentes de voz como Siri, da Apple, e Alexa, da Amazon, que são capazes de interpretar comandos e interagir com os usuários de forma cada vez mais natural. Recentemente, uma empresa sul-coreana lançou um serviço de “memorial de IA”, que permite que as pessoas mantenham uma presença virtual após a morte, possibilitando que familiares e amigos conversem com uma versão digital da pessoa falecida.

Embora essa tecnologia tenha aplicações legítimas, como preservar memórias e histórias de vida, também pode ser utilizada de forma maliciosa. Os golpes em ligações de voz com uso de IA podem se tornar ainda mais convincentes quando os golpistas aproveitam as vozes postadas pelas próprias vítimas em redes sociais. Com o acesso a essas gravações de voz, os criminosos podem criar áudios falsos que imitam com precisão a voz da vítima, aumentando a credibilidade.

Além disso, os golpistas podem usar IAs sofisticadas para criar diálogos mais interativos, respondendo às perguntas das vítimas de forma convincente. Isso pode fazer com que as vítimas acreditem que estão realmente falando com uma pessoa real, aumentando a eficácia do golpe.

A falta de regulamentação específica torna difícil combater esse tipo de fraude. Atualmente, as leis de direitos autorais não protegem a voz de uma pessoa, o que facilita a manipulação e o uso indevido da tecnologia de clonagem de voz. Para lidar com esse problema, alguns legisladores têm proposto leis que aumentariam as penalidades para o uso de IA para se passar por pessoas. No entanto, a questão continua sendo um desafio, pois é necessário encontrar um equilíbrio entre a proteção da privacidade e a liberdade de expressão.

Golpes com uso de fotos do usuário

Outra forma de golpe é a criação de perfis falsos com base nas fotos das vítimas. Os criminosos podem utilizar fotos encontradas em redes sociais ou em outras fontes online. Com esses perfis falsos, os golpistas podem se passar por outras pessoas, enganando amigos ou familiares das vítimas. Essa técnica é comumente usada em golpes de plataformas de romance online, onde os criminosos criam perfis falsos para atrair a atenção das vítimas e, eventualmente, solicitar dinheiro ou informações pessoais.

Esses golpes podem ser ainda mais convincentes quando os criminosos combinam fotos com informações pessoais obtidas online. Dessa forma, os perfis falsos parecem extremamente autênticos, tornando difícil para as vítimas identificar que estão sendo enganadas. É importante que as pessoas estejam cientes dessas práticas e adotem medidas de segurança ao interagir online, como verificar a autenticidade dos perfis com quem estão se comunicando e nunca compartilhar informações pessoais ou financeiras com desconhecidos.

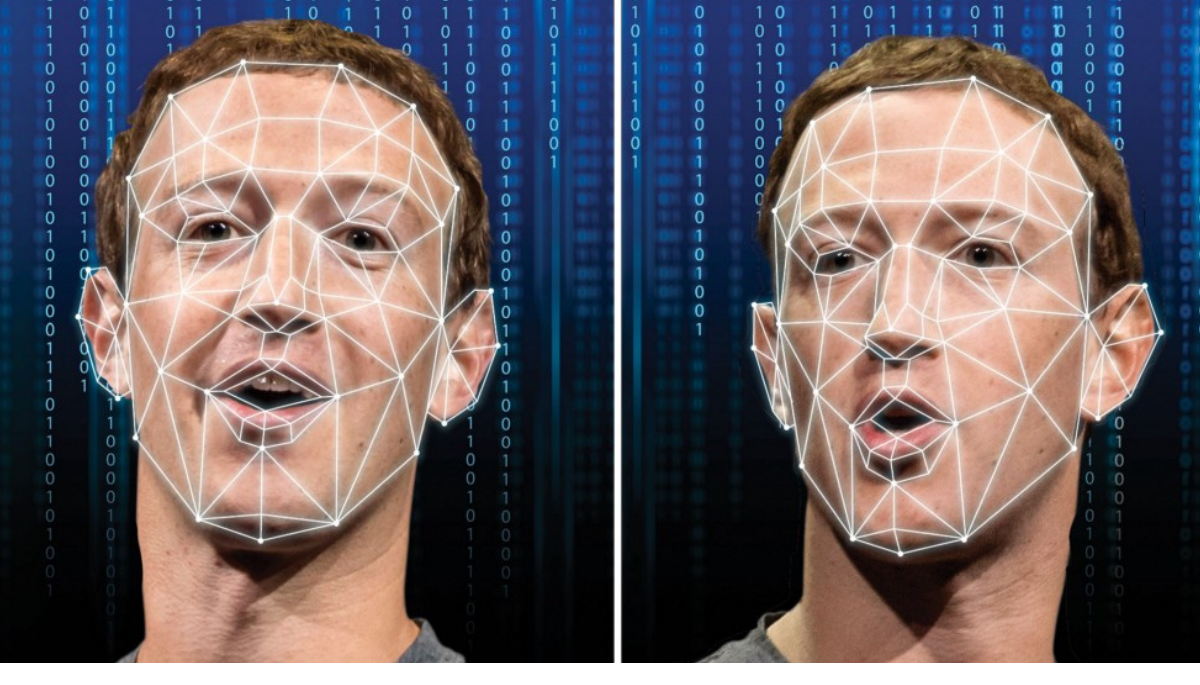

Golpes por vídeo com Deepfakes

Os golpes por vídeo com uso de Deepfakes, que são vídeos falsos criados com IA, também têm se tornado uma preocupação crescente. Com o avanço da tecnologia, os criminosos podem criar vídeos que mostram pessoas reais fazendo ou dizendo coisas que nunca fizeram, o que pode ser usado para difamar alguém ou para extorquir dinheiro. Os Deepfakes podem ser extremamente convincentes, tornando difícil para as pessoas distinguir entre vídeos reais e falsos.

O uso de Deepfakes já ganhou a atenção e preocupação de governos ao redor do mundo. A China, até então, foi pioneira em legislar o uso de Deepfakes de forma ampla. A legislação chinesa, muito mais abrangente que as introduzidas por alguns governos ocidentais, é descrita como um mecanismo para preservar a estabilidade social. Ela proíbe especificamente a produção de deepfakes sem o consentimento do usuário e exige a identificação específica de que o conteúdo foi gerado por meio de Inteligência Artificial (IA).

Um exemplo recente e preocupante ocorreu após a invasão russa na Ucrânia, quando um vídeo Deepfake foi divulgado nas redes sociais, mostrando o presidente ucraniano, Volodymyr Zelensky, supostamente ordenando suas tropas a se renderem, o que nunca aconteceu na realidade. Outro caso emblemático aconteceu em Hong Kong, onde um funcionário financeiro foi enganado a pagar 25 milhões de dólares após participar de uma videoconferência com supostos membros seniores de sua empresa, que na verdade eram deepfakes.

Esses golpes podem ter consequências devastadoras, especialmente quando envolvem figuras públicas ou pessoas comuns que são vítimas de difamação. Além disso, os Deepfakes também podem ser usados em golpes de phishing, onde os criminosos enviam vídeos falsos para as vítimas, tentando convencê-las a clicar em links maliciosos ou compartilhar informações pessoais. Para se proteger desses golpes, é importante estar ciente da existência de Deepfakes e verificar sempre a autenticidade dos vídeos antes de compartilhar ou tomar qualquer ação com base neles.

Como identificar padrões do uso de IAs em golpes

Identificar padrões do uso de inteligências artificiais (IAs) em golpes pode ser desafiador, mas algumas pistas podem ajudar a identificar potenciais fraudes. Uma das principais características é a personalização excessiva das mensagens ou interações. IAs podem analisar grandes quantidades de dados para criar mensagens altamente personalizadas, o que pode parecer suspeito se a pessoa não tiver uma relação prévia com o remetente. Além disso, erros gramaticais ou de coesão textual podem indicar que a mensagem foi gerada por uma IA, especialmente se a comunicação é em um idioma estrangeiro para o suposto remetente.

Outro padrão comum é a solicitação de informações pessoais ou financeiras de forma rápida e insistente. Golpistas que usam IAs muitas vezes tentam induzir a vítima a fornecer informações sensíveis com urgência, usando táticas de manipulação emocional. Além disso, a falta de informações específicas ou respostas evasivas a perguntas diretas podem indicar que a interação não está ocorrendo com uma pessoa real.

Dicas para se proteger

Para evitar cair em possíveis golpes digitais, é importante adotar algumas medidas de segurança. A seguir, veja algumas instruções para não cair em possíveis golpes digitais:

Na dúvida, fale pessoalmente

Na era digital, é fácil cair em golpes online devido à sofisticação das técnicas utilizadas pelos criminosos. Uma maneira eficaz de se proteger é adotar a prática de, na dúvida, falar pessoalmente com a pessoa ou empresa envolvida. Se receber uma solicitação de informações sensíveis por e-mail, mensagem ou telefone, é sempre recomendável verificar a autenticidade da solicitação por meio de um contato direto.

Além disso, ao lidar com transações financeiras ou compartilhamento de informações pessoais, é prudente evitar fornecer dados sensíveis online. Opte por realizar essas transações pessoalmente ou por canais seguros e verificados. Essa prática simples pode ajudar a evitar cair em golpes digitais e proteger suas informações pessoais e financeiras.

Confira o número de telefone

Para verificar a autenticidade de um número de telefone em caso de suspeita de golpe, uma medida simples é realizar uma pesquisa na internet. Utilize motores de busca para verificar se o número está associado a golpes conhecidos. Além disso, procure por informações sobre a empresa ou pessoa que está entrando em contato, verificando se há relatos de fraudes relacionadas ao número. Em alguns casos, é possível encontrar alertas de golpes compartilhados por outras pessoas, o que pode ajudar a confirmar se a comunicação é legítima.

Desligue e ligue você para a pessoa, se houver suspeita

Desligar e ligar para a pessoa em caso de suspeita pode ser uma estratégia eficaz para reafirmar e retestar a legitimidade da ligação. Isso porque, em muitos casos de golpes, os criminosos podem estar utilizando inteligência artificial (IA) para imitar a voz de outra pessoa. Ao desligar e ligar você mesmo, você pode confirmar se a voz e o comportamento do interlocutor são consistentes com o que você espera. Além disso, essa medida pode ajudar a evitar possíveis tentativas de clonagem de números ou falsificação de identidade, comuns em fraudes telefônicas.

Faça a confirmação com uma videochamada e faça perguntas que só a pessoa real saberia responder

Em situações de suspeita de golpes com o uso de inteligência artificial (IA), como deepfakes ou clonagem de voz, uma medida eficaz é realizar uma videochamada para confirmar a identidade da pessoa. Durante a videochamada, faça perguntas que apenas a pessoa real seria capaz de responder, como detalhes sobre experiências compartilhadas ou informações específicas sobre seu relacionamento.

Essas perguntas podem ajudar a verificar se você está realmente interagindo com a pessoa esperada, pois os golpistas podem ter dificuldade em responder a essas perguntas de forma convincente. Além disso, ao realizar uma videochamada, você pode observar a expressão facial e o comportamento da pessoa, o que pode ajudar a identificar sinais de falsificação.

Não empreste dinheiro sem verificar a identidade alheia

Não emprestar dinheiro sem verificar a identidade da pessoa é uma medida fundamental para evitar golpes. Ao ser abordado por alguém solicitando dinheiro emprestado, especialmente de forma não presencial, é importante verificar cuidadosamente a identidade da pessoa. Solicite informações pessoais que só a pessoa real seria capaz de fornecer e confirme-as por meio de documentos ou outros meios de verificação. Além disso, esteja atento a solicitações urgentes ou pressões emocionais, pois esses são sinais comuns em golpes financeiros.

Observe trejeitos, compare e procure por erros de imagem

Observar trejeitos, comparar informações e procurar por erros de imagem são medidas importantes para identificar possíveis golpes que utilizam inteligência artificial (IA) para imitar pessoas. Ao interagir com alguém online, preste atenção em como essa pessoa se comunica, seus trejeitos e padrões de linguagem. Se algo parecer fora do comum ou inconsistente com o comportamento habitual da pessoa, pode ser um sinal de que você está lidando com uma IA ou com alguém se passando por outra pessoa.

Além disso, compare as informações fornecidas pela pessoa com informações conhecidas sobre ela. Erros de imagem, como falhas na edição de fotos ou vídeos, também podem ser indicativos de que a comunicação não é autêntica.

Veja também

Fontes: ABC, Seacoastbank e PWC.

Revisão do texto feita por: Pedro Bomfim